Kein Neuwagen kommt heute mehr ohne mindestens eine Kamera auf die Straße. Mittelfristig könnten mehr als ein Dutzend der optischen Sensoren Innenraum und Umgebung des Autos überwachen. Und auch die Leistungsfähigkeit der Kamerasysteme wächst, verspricht Zulieferer Bosch. Nicht zuletzt durch die Hilfe Künstlicher Intelligenz.

Neben der KI treibt ein zweiter technische Megatrend die Evolution der Fahrzeugsensorik voran: die Zentralisierung. Statt jedem Sensor sein eigenes Steuergerät einzubauen, werden die Daten zunehmend in Zentralsteuergeräten verarbeitet. "Wir trennen quasi Augen und Gehirn des Autos“, beschreibt es Rolf Nicodemus, Chief Technology Officer, Vice President ADAS Components beim Zulieferer Bosch. „Im zentralen Steuergerät können wird die Daten aus den Sensoren sehr viel effektiver verarbeiten. Nur so lassen sich die künftigen großen Datenmengen handhaben."

Kameraköpfe: Linse, Gehäuse und Imager-Chip

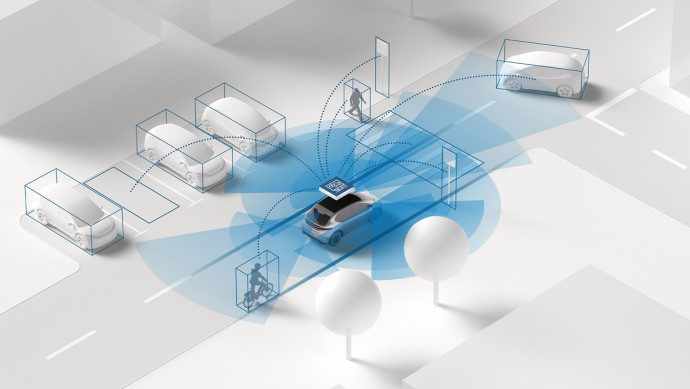

Bosch spricht in diesem Zusammenhang bereits von "Kameraköpfen" statt von Kameras. Die modular nutzbaren Sensoreinheiten bestehen im Wesentlichen nur noch aus optischen Komponenten wie der Linse, dem Gehäuse und dem Imager-Chip. Alle andere Technik ist ausgelagert. Die Einheiten werden dadurch klein, günstig und flexibel nutzbar. Bis zu 16 einzelne Kameras könnten so künftig im und am Fahrzeug eingesetzt werden, sagt Nicodemus. Die Sensoren beobachten den Verkehr, zeigen mögliche Hindernisse in der Umgebung und überwachen nicht zuletzt den Innenraum. Viele dieser Daten kommen den Assistenz- und Sicherheitssystemen zugute. Nicht nur Notbremsanlage und Tempomat profitieren, auch Airbags und Gurtstraffer können viel zielgerichteter Reagieren, wenn sie wissen, wer wo und wie im Auto sitzt.

Auch interessant:

- Bosch: Konzern streicht Prognose zusammen

- Bosch: Sparmaßnahmen auch in der Zentrale

- Bosch stellt Nutzfahrzeuggeschäft neu auf: E-Lkw im Fokus

Eine wichtige Rolle spielen die Kameras auch für das autonome Fahren, wo sie im Verbund mit anderen Sensoren die Umgebung überwacht. Wie große die Möglichkeit der Optik-Sensoren in Kombination mit einer leistungsfähigen Bilderkennung ist, darüber streitet sich die Branche bislang. Elektroautobauer Tesla verzichtet bei der "Full Self Driving"-Technologie in seinen aktuellen Serienmodellen sogar auf Radarunterstützung und vertraut allein der Kamera. Auch das für 2026 angekündigten Cyber Cab scheint sich allein per Bilderkennung zu orientieren. Die Kalifornier sind damit aktuell Außenseiter. Aufgrund mehrerer Unfälle im Autopilot-Modus müssen sie sich zudem harsche Kritik an ihrer Strategie gefallen lassen.

Die meisten Autohersteller setzen neben dem Radar und Kameras zusätzlich noch die relativ teure Lidar-Technik ein. Mercedes verpackt die Sensoren relativ unauffällig, etwa in der Front. Andere Autobauer wie Volvo oder Nio setzen ihren Modellen selbstbewusst ein Lidar-Geweih aufs Dach. Die Frage, ob das immer so bleiben muss, hält Nicodemus noch nicht für final geklärt. Er sieht für die Umfeldbeobachtung großes Potenzial beim Thema Künstliche Intelligenz. Sie könne die Wahrnehmung der Sensorik stark erweitern. "Wenn wir beispielsweise Kameraköpfe und Radarsensoren gemeinsam trainieren lassen, können wir eine Übertragung von Kontextwissen zwischen den beiden Systemen beobachten. Wird anschließend die Kamera abgeschaltet, sieht der Radar dauerhaft mehr als er ohne das gemeinsame Training gesehen hätte."

"Trainingslager" gleichen technische Limits der Kameratechnik aus

Mit Hilfe solcher algorithmischen "Trainingslager" lassen sich möglicherweise zahlreiche technische Limits der Kameratechnik ausgleichen. Nicodemus nennt als Beispiele eine Verbesserung der Sicht bei Dämmerung oder Nebel. Für Menschen seien die Potenziale Künstlicher Intelligenz oft schwer zu fassen, so der Physiker. Sie lässt die Sensoren jedoch viel mehr "erkennen" als die menschliche Auffassungsgabe dies könnte. "Während unser Gehirn immer versucht, Bilder zu erzeugen und zu interpretieren, kann die KI mit jeglicher Form von abstrakten Daten etwas anfangen. Sie nutzt also Informationen, die wir bewusst wegfiltern. Da steckt ein Potenzial drin, das heute noch keiner richtig überschauen kann."

Green NCAP - die umweltfreundlichsten Autos 2024

Bildergalerie

Bildergalerie

Der Ort, an dem die Künstliche Intelligenz in Zukunft sitzen wird, ist der zentrale Rechner im Fahrzeug. Bosch hat auch diesen im Programm, genauso wie die passende Software. Vor allem darauf sind sie in Stuttgart stolz: "Wir haben sehr früh erkannt, was die künstliche Intelligenz in unseren Produkten für eine Bedeutung haben wird, und dementsprechend sind wir gut aufgestellt." Grundsätzlich aber seien alle Komponenten auch mit Komponenten anderer Zulieferer kombinierbar. Für die Fahrzeughersteller ist das extrem wichtig, will man sich doch nicht komplett von einem einzigen Lieferanten abhängig machen.

Für die klassischen Automobilzulieferer und Neueinsteiger aus IT-Industrie und Chip-Fertigung wird das vernetzte Fahrzeug der nahen Zukunft zu Herausforderung und Chance. Das Potenzial am besten nutzen werden wohl die Unternehmen, die sich als Systemlieferant aufstellen und möglichst viele Bereiche beherrschen und abdecken. Ein guter Sensor allein reicht nicht mehr.